2025 AI Cyber Benchmark

Veröffentlicht am 31. März 2025

- Cyber Security

- Daten & Künstliche Intelligenz

Sind große Organisationen bereit, mit den Sicherheitsrisiken von KI umzugehen?

In den letzten zwei Jahren, seit der Veröffentlichung effizienter generativer KI-Systeme, haben große Organisationen die Einführung von Künstlicher Intelligenz beschleunigt und vielversprechende Anwendungsfälle entwickelt, um ihre Geschäftsprozesse zu unterstützen. KI-Systeme, die sich in vielerlei Hinsicht von herkömmlichen IT-Anwendungen unterscheiden (nicht-deterministisch, nicht erklärbar, Nutzung einer Vielzahl von Daten usw.), bringen jedoch neue Sicherheitsrisiken mit sich. Organisationen müssen daher ihre Governance, Methoden und Tools an diese neue Realität anpassen.

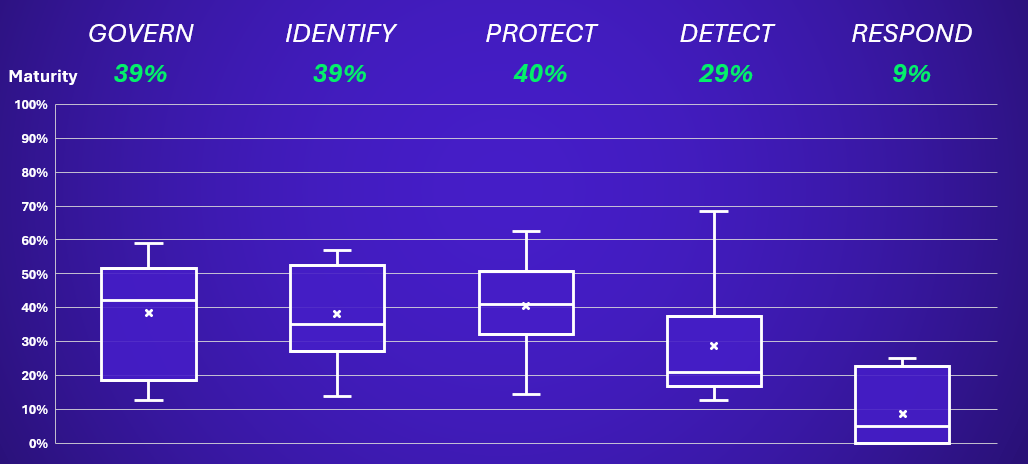

In diesem Kontext hat Wavestone seinen AI Cyber Benchmark entwickelt, um Organisationen bei der Identifizierung ihrer Prioritäten und Fokusbereiche zu unterstützen und Einblicke in die Marktreife zu gewinnen. Diese Initiative bewertet die Reife einer Organisation in Bezug auf ihre KI-Sicherheitspraktiken anhand der fünf Säulen des NIST Cybersecurity Framework: Govern, Identify, Protect, Detect und Respond.

Diese Bewertung richtet sich an alle Organisationen, die KI-Anwendungsfälle übernommen haben, von einfachen Anwendungsfällen, die öffentliche KI-Tools oder SaaS-Lösungen verwenden, bis hin zu denen, die proprietäre Modelle entwickeln und ihren Kunden anbieten.

Diese Organisationen nutzen KI-Funktionen, die in der Software integriert sind, die sie bereits verwenden. Ihre Hauptsicherheitsrisiken hängen mit der Datensicherheit und der Auswahl von Drittanbieterdiensten zusammen. Fast alle Unternehmen sind von dieser Nutzung betroffen, sei es durch „Shadow AI“ oder die geplante Integration neuer KI-Funktionen, und müssen sicherstellen, dass geeignete Governance-Rahmenbedingungen vorhanden sind.

Diese Organisationen entwerfen KI-Systeme intern, wobei Datenwissenschaftler auf bestehende Frameworks oder vortrainierten Modellen aufbauen. Ihre Hauptsicherheitsrisiken liegen in der umgebenden Infrastruktur und den Abhängigkeiten der KI-Modelle. Eine robuste Methodologie ist erforderlich, um Risiken auf Systemebene ordnungsgemäß zu identifizieren und zu mindern.

Diese Organisationen entwickeln proprietäre KI-Modelle, oft mit der Absicht, diese zu kommerzialisieren. Sie stehen einem breiteren Spektrum von KI-bezogenen Risiken gegenüber, von der Modellgestaltung über die Bereitstellung bis hin zur Nutzung durch Kunden.

Jeder dieser Ansätze birgt unterschiedliche Risikoniveaus und erfordert maßgeschneiderte Risikominderungsstrategien. Nach der Durchführung einer ersten Reihe von Bewertungen mit über 20 Organisationen präsentieren wir hier die Ergebnisse und wichtigen Erkenntnisse, die wir gewonnen haben. Dies kombinieren wir mit unserer Erfahrung aus AI-Sicherheitsengagements, die in den letzten zwei Jahren durchgeführt wurden.

Wichtige Erkenntnisse aus unserem AI Cyber Benchmark

- Die Risiken von GenAI sind vielfältig (Cybersicherheit, Datenschutz, Verzerrung, Transparenz, Leistung) und sehr spezifisch.

- Neue KI-Technologien führen zu drei neuen Angriffstypen: Poisoning-, Oracle- und Evasion-Angriffen.

- Als Reaktion darauf vervielfachen sich internationale Vorschriften, was für multinationale Unternehmen zusätzliche Komplexität schafft.

- Sicherheitsmaßnahmen variieren je nach KI-Anwendungsfällen, die in drei Typen unterteilt werden: Nutzer, Orchestratoren und fortgeschrittene Entwickler.

- Während 87 % der Unternehmen in unserem Panel Governance-Elemente definiert haben, haben nur 7 % über die notwendige Expertise, um auf aufkommende Risiken zu reagieren.

- Die reifsten Unternehmen gehen die Herausforderung der fehlenden Fachkompetenz an, indem sie ein integriertes Governance-Modell übernehmen.

- 64 % der Unternehmen haben eine KI-Sicherheitsrichtlinie implementiert, um ein grundlegendes Sicherheitsniveau für KI-Projekte zu etablieren.

- 72 % haben ihre Sicherheitsprozesse in Projekten angepasst, um KI-spezifische Risiken zu adressieren.

- 40 % der Unternehmen haben ihre Prozesse zur Bewertung der Reife von Drittanbietern für KI-gestützte Lösungen angepasst.

- 43 % der Unternehmen haben Sicherheitskriterien in die Modellwahl für Anwendungsfälle aufgenommen.

- Nur 7 % der Unternehmen sind richtig ausgestattet (intern oder mit Unterstützung von Anbietern), um sich gegen modellbezogene Angriffe zu verteidigen.

- Um Vertrauensniveaus zu validieren, bleiben KI-Red-Teams der bevorzugte Ansatz. Nur 7 % der Unternehmen verfügen über die interne Expertise, um diese durchzuführen, und müssen auf externe Spezialisten zurückgreifen.

- KI-Anwendungen werden selten über das SOC überwacht. Infrastruktur- und Anwendungsprotokolle werden jedoch in der Regel gut gesammelt (71 %), um Ermittlungen im Falle von Vorfällen zu unterstützen. Die forensische Analyse von KI-Modellen bleibt technisch sehr komplex, und nur wenige Organisationen weltweit sind in der Lage, sie durchzuführen.

KI beeinflusst die Cybersicherheit auf zwei weitere Weise: Sie stärkt die Verteidigung, indem sie bestimmte Aufgaben automatisiert, wird jedoch auch von Cyberkriminellen ausgenutzt, mit einem Anstieg von Deepfakes, KI-unterstütztem Phishing und KI-mitgeschriebenem Malware im Jahr 2024. Organisationen müssen diese Bedrohungen in ihre Überwachung integrieren und KI-Tools einsetzen, um diesen neuen Angriffen entgegenzuwirken. Weitere Informationen finden Sie hier: The industrialization of AI by cybercriminals.

- Cyber Security

- Daten & Künstliche Intelligenz

Entdecken Sie die vollständige Analyse in unserem ausführlichen Bericht

2025 AI Cyber BenchmarkUnser Feedback aus der Praxis

Welche Trends haben wir bei der Absicherung von KI identifiziert?

Der Markt hat schnell auf das Aufkommen von KI reagiert. Heute haben 87 % der Organisationen in der Benchmark eine Governance definiert, um das Thema Vertrauenswürdige KI anzugehen. Cybersicherheit ist in der Tat nur ein Aspekt von vertrauenswürdiger KI, neben Datenschutz, Bias-Management, Robustheit, Genauigkeit…

Hauptsächlich haben wir zwei Ansätze beobachtet:

- Integriertes Modell bei rund 60 % unserer Kunden, mit einem „AI-Hub“ als Schlüsselkompetenzen rund um KI (Recht, Sicherheit, Datenschutz, CSR), um Kommunikation zu erleichtern und eine schnelle Einführung von Themen zu ermöglichen. Dies hilft, die Bewertung von Anwendungsfällen zu zentralisieren, eine vertrauenswürdige KI-Community aufzubauen und die Weiterbildung der Teams zu beschleunigen.

- Dezentralisiertes Modell bei rund 10 % unserer Kunden, bei dem die KI-Spezifika über bestehende Teams und Prozesse angegangen werden. Obwohl die Umsetzung langsamer erfolgt, hilft es, eine dedizierte Governance-Struktur zu schaffen und Redundanzen mit bestehenden Prozessen zu vermeiden.

Aber wie kann man KI-Risiken in der Praxis effektiv managen?

71 % der Organisationen in unserer Benchmark haben ihren Projektlebenszyklusprozess an die Risiken von KI angepasst. 64 % haben ein KI-Sicherheitsframework definiert, entweder durch die Etablierung einer dedizierten Sicherheitsrichtlinie oder durch die Anpassung ihres gesamten Sicherheitskorpus. Und dies sollte der erste Schritt für jedes Unternehmen sein, das versucht, ein KI-Sicherheitsframework aufzubauen.

Ein wichtiger Erfolgsfaktor ist es, nicht das Rad neu zu erfinden, sondern auf bestehenden Prozessen und Dokumenten aufzubauen und, wo relevant, Risiken, Maßnahmen, Kontrollen und Verifizierungsschritte spezifisch für KI hinzuzufügen. Zum Beispiel könnte der Risikobewertungsfragebogen spezifische Fragen zu KI enthalten, wie:

- Was ist der Kontext und der beabsichtigte Zweck dieser KI?

- Würde das Ergebnis von einem Menschen genutzt oder direkt als Eingabe in einen automatisierten Prozess verwendet?

- Was ist das erwartete Leistungsniveau des KI-Systems?

- Was wären die Auswirkungen einer Fehlfunktion auf Einzelpersonen?

Das Thema der Fachkompetenz bleibt jedoch eine Schlüsselherausforderung: KI ist ein spezialisiertes Thema, und Expertise kann knapp sein. Nur 57 % der Organisationen in unserem Panel haben interne oder externe Experten für KI-Sicherheitsthemen identifiziert. Daher wird Schulung, Sensibilisierung und die Identifizierung fehlender Expertise zur Anpassung dieser Rekrutierungsstrategien entscheidend sein.

Viele klassische Sicherheitsmaßnahmen können problemlos auf Künstliche Intelligenz angewendet werden, das aber reicht nicht aus, insbesondere bei kritischen Anwendungsfällen. Das erforderliche Sicherheitsniveau hängt von Ihrer KI-Nutzung ab, wie zu Beginn dieser Studie beschrieben:

- KI-Nutzung: Organisationen in dieser Kategorie, die hauptsächlich Drittanbieter-KI-Lösungen nutzen, müssen sich auf Datensicherheit und Lieferantenrisikomanagement konzentrieren. 40 % der Organisationen in unserer Benchmark haben ihre Drittanbieterevaluierungsmethodik für KI-Anbieter angepasst. Wichtige Themen umfassen das Bewusstsein für KI-Risiken, Governance, Richtlinien und Compliance (z. B. KI-Gesetz und Vermeidung von „Shadow AI“) sowie die Implementierung eines Risikomanagementrahmens für Drittanbieter im Bereich KI.

- KI-Orchestrierung: Diese Organisationen integrieren Drittanbieter-KI-Modelle in ihre Produkte/Dienstleistungen. Sicherheitsprioritäten umfassen die Gewährleistung der Robustheit von KI-Plattformen und die Sicherung von Datenspeichern. 43 % der Organisationen haben bereits einen Modellauswahlprozess implementiert, der Sicherheitskriterien umfasst. Es ist entscheidend, KI-Plattformen zu sichern, KI-zugängliche Datenspeicher zu schützen (z. B. RAG-basierte Architekturen) und Sicherheitswerkzeuge für kritische Anwendungsfälle zu erweitern. Mit dem Wachstum der KI-Integration wird die Implementierung von MLSecOps-Praktiken unerlässlich.

- KI-Entwicklung mit fortgeschrittenem Niveau: Organisationen, die proprietäre KI-Modelle entwickeln, tragen die volle Verantwortung für ihre Sicherheitsarchitektur und benötigen ein hohes Maß an Reife. Bis heute haben nur 7 % der Organisationen in unserem Panel Maßnahmen zur Erkennung und Abwehr von bösartigen Eingabeaufforderungen und anderen KI-Bedrohungen umgesetzt. Prioritäten umfassen die Sicherung aller Werkzeuge und Prozesse, die von MLOps-Teams zum Aufbau von KI verwendet werden, die Gewährleistung eines fortgeschrittenen Schutzes für ML-Schlüsselressourcen und die Verbesserung von Erkennungs- und Reaktionsfähigkeiten.

Jede dieser KI-Posturen bringt ihre eigenen Risiken und notwendigen Risikominderungsstrategien mit sich. Glücklicherweise wird der Markt für Sicherheitslösungen zunehmend vielfältiger, auch mit Open-Source-Lösungen. Organisationen müssen sicherstellen, dass sie sich nicht nur auf die nativen Sicherheitsmaßnahmen ihrer Anbieter oder auf ihre Annahmen zur Cybersicherheit verlassen, sondern ein Schutzniveau implementieren, das auf ihre Risiken abgestimmt ist.

Monitoring und Testing sind entscheidend, um Schutzmaßnahmen zu ergänzen. Obwohl viele Tools bereits verfügbar sind, haben Organisationen oft noch keine Strategie in diesem Bereich definiert:

Beim Monitoring sammeln 71 % der Organisationen Anwendungsprotokolle, aber nur 13 % senden diese an ihr SOC, um Alarme zu generieren. Organisationen sind in der kontinuierlichen Bewertung der Leistung ihrer Modelle tendenziell reifer, da 36 % der Organisationen Metriken in diesem Bereich definiert haben, insbesondere solche mit etablierten Data-Science-Prozessen.

Bezüglich AI-Pentesting (auch bekannt als AI Red Teaming) haben 64 % der Organisationen einen spezifischen Testprozess für ihre Anwendungsfälle implementiert, jedoch in der Regel nur für grundlegende Angriffe und manuell ausgeführt. Nur 7 % haben einen Testprozess implementiert, der Automatisierung umfasst und fortgeschrittene Tests durchführt, die auf die verwendeten Algorithmen und Technologien abgestimmt sind.

Für Organisationen ist es entscheidend geworden, eine Strategie in diesen beiden Bereichen zu definieren: Welche Anwendungsfälle sind am kritischsten und müssen überwacht und getestet werden? Wie kann ich meine SOC-Teams schulen, um Alarme effektiv zu bearbeiten? Wie kann ich Tests für Anwendungsfälle skalieren, die sich schnell weiterentwickeln?

Der Bereich der KI-Vorfallerkennung bleibt noch unerschlossen: Die Reife in diesem Bereich liegt bei nur 9 %. Viele Organisationen verlassen sich immer noch auf ihre allgemeinen Vorfallreaktions- und Untersuchungsprozesse, ohne KI-spezifische Aspekte zu berücksichtigen. Nur 29 % haben damit begonnen, Vorfallreaktionsszenarien zu integrieren, die KI-Systeme betreffen.

Da kritische Anwendungsfälle, insbesondere mit dem Aufkommen agentenbasierter KI, immer mehr an Bedeutung gewinnen, wird es notwendig sein, die Reaktionsfähigkeiten anzupassen. Erste Initiativen sind bereits entstanden: Die Carnegie Mellon University hat ein AI-CSIRT eingerichtet, um KI-Vorfälle zu analysieren und darauf zu reagieren, während die ANSSI, die französische Cybersicherheitsagentur, bei dem letzten AI Summit eine groß angelegte Krisenübung zu einem KI-bezogenen Vorfallszenario durchgeführt hat.

Die Sicherung von KI sollte eine Priorität sein, aber vergessen wir nicht, dass dies nur eine der Facetten der Auswirkungen von KI auf die Cybersicherheit ist. KI kann helfen, Ihre Cybersicherheit zu stärken: Konkrete Anwendungsfälle tauchen auf, um bestimmte Aufgaben zu automatisieren und zu beschleunigen. Vom Erleichtern der mehrsprachigen Sensibilisierung bis hin zur Vorverarbeitung von Sicherheitsalarmen und sogar der Vorab-Analyse von Sicherheitsfragebögen deiner Lieferanten gibt es bereits Ansätze, die deine Teams unterstützen können. Wir haben echte Rückmeldungen aus der Praxis gesehen, die eine Effizienzsteigerung von 15 % bis 30 % je nach Anwendungsfall zeigen.

- Cyber Security

- Daten & Künstliche Intelligenz

Discover the full analysis in our detailed report

2025 AI Cyber BenchmarkAuthors

-

Gérôme Billois

Partner – Frankreich, Paris

Wavestone

LinkedIn -

Thomas Argheria