AI Cyber Benchmark 2025

Publié le 31 mars 2025

Les grandes entreprises peuvent-elles gérer les risques liés à la sécurité de l’IA ?

Ces deux dernières années et depuis la sortie des systèmes d’IA générative efficaces, les grandes entreprises ont accéléré leur adoption de l’intelligence artificielle, développant des cas d’usage prometteurs pour soutenir leurs opérations commerciales. Cependant, les systèmes d’IA, qui diffèrent des applications informatiques traditionnelles sur plusieurs aspects (non déterministes, non explicables, utilisant une grande variété de données, etc.), introduisent de nouveaux risques en matière de sécurité. Les organisations doivent donc adapter leur gouvernance, leurs méthodologies et leurs outils pour s’adapter à cette nouvelle réalité.

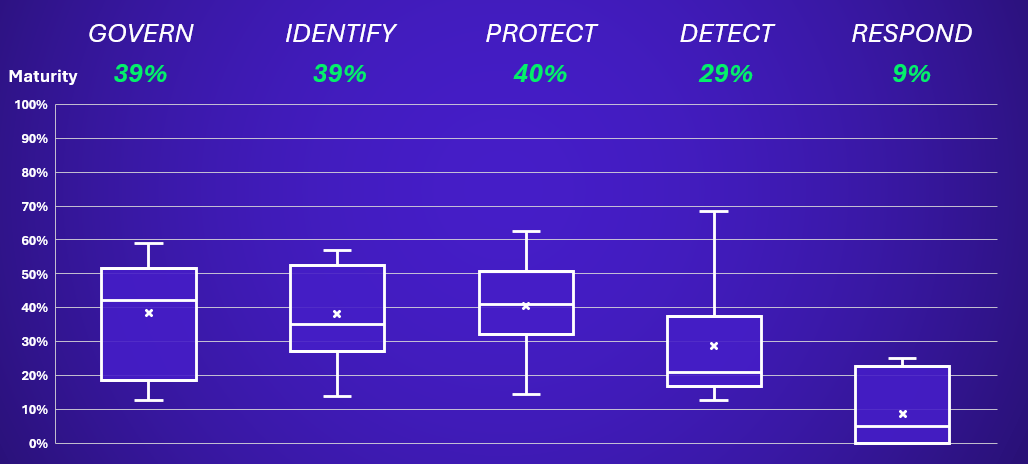

C’est dans ce contexte que nous avons développé notre AI Cyber Benchmark. Son objectif ? Aider les entreprises à identifier leurs priorités et domaines de prédilection, ainsi qu’à obtenir un aperçu de la maturité du marché. Cette initiative évalue la maturité d’une organisation en matière de pratiques liées à la sécurité de l’IA, et ce, en se basant sur les cinq piliers du NIST Cybersecurity Framework : gouverner, identifier, protéger, détecter et répondre.

Ce benchmark s’adresse à toutes les organisations ayant adopté des cas d’usage de l’IA, qu’il s’agisse d’utilisateurs simples utilisant des outils d’IA publics ou des solutions SaaS, ou d’entreprises développant des modèles propriétaires qu’elles proposent à leurs clients.

Ces organisations utilisent des fonctionnalités de l’IA intégrées dans les logiciels qu’elles utilisent déjà. Leurs principaux risques sont liés à la sécurité des données et au choix des fournisseurs tiers. Presque toutes les entreprises sont concernées par cet usage, que ce soit à travers l’« IA fantôme » ou l’intégration prévue de nouvelles fonctionnalités d’IA, et doivent s’assurer qu’un cadre de gouvernance approprié est en place.

Ces organisations conçoivent des systèmes d’IA en interne, avec des data scientists qui s’appuient sur des cadres existants ou des modèles pré-entraînés. Leurs principaux risques résident dans l’infrastructure environnante et les dépendances des modèles d’IA. Une méthodologie robuste est nécessaire pour identifier et atténuer correctement les risques au niveau du système.

Ces organisations développent des modèles d’IA propriétaires, souvent dans le but de les commercialiser. Elles font face à un éventail plus large de risques, allant de la conception du modèle à son déploiement et à son utilisation par les clients.

Ces approches révèlent de nombreux défis qui nécessitent des stratégies de gestion des risques adaptées. Après une première série d’évaluations auprès de plus de 20 organisations, nous partageons ici les résultats et les enseignements clés, enrichis par deux ans de mission et d’expérience acquise en sécurité de l’IA.

Les principaux enseignements du AI Cyber Benchmark

- Les risques liés à l’IA générative sont multiples (cybersécurité, protection des données, biais, transparence, performance) et très spécifiques.

- Les nouvelles technologies de l’IA introduisent trois types d’attaques inédites : le poisoning, les attaques oracle et les attaques d’évasion.

- En réponse, les régulations internationales se multiplient, ajoutant de la complexité pour les multinationales.

- Les actions de sécurité varient en fonction des cas d’usage de l’IA. On peut les classer par profils : utilisateurs, orchestrateurs et créateurs avancés.

- Bien que 87 % des entreprises de notre panel aient défini des éléments de gouvernance, seulement 7 % disposent de l’expertise nécessaire pour faire face aux risques émergents.

- Les entreprises les plus matures abordent le défi des compétences en adoptant un modèle de gouvernance intégré.

- 64 % des entreprises ont mis en place une politique de sécurité de l’IA pour établir un niveau de sécurité minimum pour les projets d’IA.

- 72 % ont adapté leurs processus de sécurité dans les projets pour traiter les risques spécifiques à l’IA.

- 40 % des entreprises ont ajusté leurs processus d’évaluation de la maturité des fournisseurs afin de prendre en compte les solutions basées sur l’IA.

- 43 % des entreprises ont intégré des critères de sécurité pour guider la sélection des modèles pour les cas d’usage.

- Seules 7 % des entreprises sont correctement équipées (en interne ou avec le soutien de fournisseurs) pour se défendre contre les attaques spécifiques aux modèles.

- Pour valider les niveaux de confiance, les « red teams » en IA restent l’approche privilégiée. Cependant, seulement 7 % des entreprises ont l’expertise en interne pour les réaliser et doivent s’appuyer sur des spécialistes externes.

- Les applications d’IA sont rarement surveillées par le biais du SOC (Security Operations Center). Cependant, les logs d’infrastructure et d’applications sont généralement bien collectés (71 %) pour soutenir les enquêtes en cas d’incident. L’analyse approfondie des modèles d’IA reste techniquement très complexe, et seules quelques organisations dans le monde sont capables de la réaliser.

L’IA impacte la cybersécurité de deux autres manières : elle renforce la défense en automatisant certaines tâches, mais elle est également exploitée par les cybercriminels, avec une augmentation des deepfakes, du phishing alimenté par l’IA et des malwares coécrits par IA en 2024. Les organisations doivent intégrer ces menaces dans leur surveillance et adopter des outils d’IA pour contrer ces nouvelles attaques. Vous pouvez trouver plus d’informations sur le sujet ici : L’industrialisation de l’IA par les cybercriminels : faut-il vraiment s’inquiéter ?.

Nos retours terrain

Quelles sont les tendances que nous avons identifiées en matière de sécurisation de l’IA ?

Le marché a réagi rapidement à l’arrivée de l’IA. Aujourd’hui, 87 % des organisations dans le benchmark ont défini une gouvernance pour aborder la question de l’IA digne de confiance. En effet, la cybersécurité n’est qu’un des aspects de l’IA digne de confiance, aux côtés de la protection de la vie privée, de la gestion des biais, de la robustesse, de la précision, etc.

Nous avons observé deux approches principales :

- Un modèle intégré (environ 60 % de nos clients), via un « AI Hub » rassemblant les compétences clés de l’IA (juridique, sécurité, confidentialité, RSE) et facilitant ainsi la communication et la maitrise rapide de ses sujets. Cela permet de centraliser l’évaluation des cas d’usage, de créer une communauté autour de l’IA digne de confiance, et d’accélérer la montée en compétences des équipes.

- Un modèle décentralisé (environ 10 % de nos clients), où les spécificités de l’IA sont abordées via les équipes et processus existants. Bien que plus lent à mettre en place, il permet de créer une structure de gouvernance dédiée et d’éviter la redondance avec les processus déjà en place.

En pratique, comment gérer efficacement les risques liés à l’IA ?

71 % des organisations de notre benchmark ont adapté leur processus de cycle de vie des projets aux risques de l’IA. 64 % ont défini un cadre de sécurité pour l’IA, soit en établissant une politique de sécurité dédiée, soit en adaptant leur corpus de sécurité global. Cela devrait être la première étape pour toute entreprise cherchant à mettre en place un cadre de sécurité pour l’IA.

Un facteur clé de succès est de ne pas réinventer ce qui existe déjà et de s’appuyer sur les processus et documents existants, en ajoutant, le cas échéant, des risques, mesures, contrôles et étapes de vérification spécifiques à l’IA. Par exemple, le questionnaire de qualification des risques peut inclure des questions spécifiques sur l’IA, telles que :

- Quel est le contexte et l’objectif prévu de cette IA ?

- Le résultat serait-il utilisé par un humain ou directement comme entrée dans un processus automatisé ?

- Quel est le niveau de performance attendu du système d’IA ?

- Quel serait l’impact d’un dysfonctionnement sur les individus ?

Cependant, la question des compétences reste un défi majeur : l’IA est un domaine spécialisé, et l’expertise peut être rare. Seules 57 % des organisations de notre panel ont identifié des experts internes ou externes sur les sujets de sécurité de l’IA. Par conséquent, la formation, la sensibilisation et l’identification des compétences manquantes pour adapter les stratégies de recrutement seront essentielles.

Nombreuses sont les mesures de sécurité classiques pouvant être adaptées à l’intelligence artificielle, mais cela ne suffit pas, en particulier pour les cas d’usage critiques. Le niveau de sécurité requis dépend de votre posture vis-à-vis de l’IA, comme décrit dans l’introduction de cette étude :

- Utilisateurs d’IA : Principalement axées sur l’utilisation de solutions d’IA tierces, les organisations de cette catégorie doivent se concentrer sur la sécurité des données et la gestion des risques liés aux fournisseurs. 40 % des organisations de notre benchmark ont adapté leur méthodologie d’évaluation des fournisseurs aux prestataires d’IA. Les principaux points d’attention incluent la sensibilisation aux risques liés à l’IA, la gouvernance, les politiques et la conformité (nous pensons notamment à l’AI Act ou au phénomène de « Shadow AI »), ainsi que la mise en place d’un cadre de gestion des risques tiers pour l’IA.

- Orchestrateurs d’IA : Ces organisations intègrent des modèles d’IA tiers dans leurs produits ou services. Les priorités en matière de sécurité incluent la robustesse des plateformes d’IA et la sécurisation des bases de données. 43 % des organisations ont déjà mis en place un processus de sélection des modèles incluant des critères de sécurité. Il est essentiel de sécuriser les plateformes d’IA, de protéger les bases de données accessibles à l’IA (comme les architectures basées sur le RAG) et d’enrichir les outils de sécurité pour les cas d’usage critiques. À mesure que l’intégration de l’IA se développe, l’adoption des pratiques MLSecOps devient incontournable.

- Créateurs avancés d’IA : Les organisations qui développent des modèles d’IA propriétaires sont responsables de leur architecture de sécurité et doivent atteindre un niveau de maturité élevé. Actuellement, seulement 7 % des organisations de notre panel ont mis en place des mesures pour détecter et se protéger contre les sollicitations malveillantes et autres menaces liées à l’IA. Les priorités sont de sécuriser les outils et processus utilisés par les équipes MLOps pour développer l’IA, de protéger de manière renforcée les éléments clés du Machine Learning, et d’améliorer les capacités de détection et de réponse.

Chaque mode d’adoption de l’IA présente ses propres défis et nécessite des stratégies de gestion des risques adaptées. Heureusement, le marché des solutions de sécurité se diversifie, avec notamment des solutions open-source. Les organisations doivent donc s’assurer de ne pas se limiter aux mesures de sécurité proposées par leurs fournisseurs ou à leurs hypothèses sur la cybersécurité, mais bien d’adopter un niveau de protection qui corresponde à leurs risques spécifiques.

Avec une technologie souvent complexe à appréhender, la surveillance et les tests sont essentiels pour renforcer les mesures de protection. Bien que de nombreux outils soient déjà disponibles, beaucoup d’entreprises n’ont pas encore défini de véritable stratégie sur ce sujet :

- Côté surveillance, 71 % des entreprises collectent les logs applicatifs, mais seulement 13 % les envoient à leur SOC pour générer des alertes. En revanche, elles sont généralement plus avancées sur l’évaluation continue des performances des modèles : 36 % ont défini des indicateurs dans ce domaine, en particulier celles disposant de processus de data science bien établis.

- En ce qui concerne les tests d’intrusion sur l’IA (également appelés AI Red Teaming), 64 % des entreprises disposent d’un processus de test spécifique pour leurs cas d’usage, mais celui-ci se limite généralement à des attaques basiques et réalisées manuellement. Seules 7 % ont mis en place un processus automatisé incluant des tests avancés adaptés aux algorithmes et technologies utilisés.

Pour les organisations, il est devenu essentiel de définir une stratégie sur ces deux aspects : quels sont les cas d’usage les plus critiques à surveiller et tester ? Comment former les équipes SOC pour traiter efficacement les alertes ? Comment passer à l’échelle pour tester des cas d’usage en constante évolution ?

La gestion des incidents liés à l’IA en est encore à ses débuts, avec un niveau de maturité estimé à seulement 9 %. De nombreuses organisations s’appuient encore sur leurs processus généraux de réponse aux incidents, sans prendre en compte les spécificités de l’IA. À ce jour, seulement 29 % ont commencé à intégrer des scénarios liés à l’IA dans leur plan de réponse aux incidents.

Avec l’émergence croissante de cas d’usage critiques, notamment avec l’arrivée de l’IA basée sur des agents, il sera essentiel d’adapter les capacités de réponse aux incidents. Certaines initiatives voient déjà le jour : Carnegie Mellon University a mis en place un AI-CSIRT pour analyser et gérer les incidents liés à l’IA, tandis que l’ANSSI, l’Agence française de cybersécurité, a récemment organisé un exercice de crise à grande échelle sur un scénario d’attaque impliquant l’IA lors du dernier Sommet sur l’IA.

Sécuriser l’IA doit être une priorité, mais n’oublions pas que cela n’est qu’une des facettes de l’impact de l’IA sur la cybersécurité. L’IA peut aider à renforcer votre cybersécurité : des cas d’usage concrets émergent pour automatiser et accélérer certaines tâches. De la facilitation de la sensibilisation multilingue à la pré-traitement des alertes de sécurité, en passant par la pré-analyse des questionnaires de sécurité de vos fournisseurs, il existe déjà des pistes à explorer pour aider vos équipes. Nous avons observé des retours terrain réels montrant une augmentation de l’efficacité allant de 15 % à 30 %, selon les cas d’usage.

Auteurs

-

Gérôme Billois

Partner – France, Paris

Wavestone

LinkedIn -

Thomas Argheria